Vom 13.8. bis zum 16.8. fand in Vierhouten (Niederlande) die alle vier Jahre wiederkehrende »Technologie und Sicherheitskonferenz«, dieses Jahr unter dem Namen H.A.R. (Hacking at Random), statt. Ca. 3000 Hacker, Nerds, Geeks, oder wie auch immer man sagen will, verbrachten vier Tage oder mehr gemeinsam auf einem Campingplatz in Zelten und verwandelten diesen in einen riesigen, blinkenden Technologiespielplatz. Das Ganze hatte somit eher weniger den Flair einer todernsten Konferenz, obwohl natürlich auch gesellschaftspolitisch relevante Themen wie Zensur oder Copyrights vs. Freie Inhalte in Vorträgen besprochen und oft auch heftig und kontrovers diskutiert wurden.

Das Camp trug den Namen »Hacking at Random«, was auch die holländischen Strafverfolgungsbehörden auf den Plan rief – ui, vorsicht! Da sind Hacker. Die Polizei rückte zu Beginn des Camps mit einem großen Bus und ca. 20 Polizist_innen an. Diese mischten sich in Zivil unter die Leute, um die Hacker »bei der Arbeit« zu beobachten und mögliche Verstöße gegen das Gesetz gleich mal aufzuspüren. Offenbar wird die Bezeichnung Hacker immer noch, der Medienhetze der letzen 20 Jahre sei’s gedankt, fast ausschließlich mit kriminellen Handlungen in Verbindung gebracht. Dabei steht für Hacker meist der lustvoll-kreative Umgang mit Technologie im Vordergrund.1

Ein negativer Beigeschmack bei diesem und auch bei vergleichbaren Events ist der extrem niedrige Frauenanteil unter den Besucher_innen. Ein Hauptgrund dafür ist sicherlich der strukturelle Sexismus in unserer Gesellschaft (Frauen und Technik !?!) aber auch sexistische Strukturen, Handlungs- und Ausdrucksweisen innerhalb der männlich dominierten Hackerszene. Da gibt es noch einiges an politischer Arbeit in den Communities zu leisten. Diskussionen zu diesem Thema werden aber leider viel zu wenig öffentlich geführt und forciert.

Zu diesem Camp hat sich heuer auch ein Gruppe von Funkfeuer Linz aufgemacht. Die vier Tage wurden unter anderem auch dazu genutzt, das Funkfeuer Projekt in Linz2 weiter voranzutreiben und eine benutzer_innenfreundliche Administrationsoberfläche für die Funkfeuer Firmware3 zu programmieren.

Gemeinsam mit befreundeten Hackern rund um dyne.org4 veranstalteten wir auch einen Doku-Filmabend zum Thema Hausbesetzungen und Freiräume.

Im Folgenden will ich näher auf ein Thema aus einem der Vorträge eingehen, das meiner Meinung nach inhaltlich interessant war.

Der Vortrag von Annalee Newitz mit dem Titel »The Censoring Mob« beschäftigte sich mit Zensur in sozialen Netzwerken, wie zum Beispiel YouTube, Flickr oder ähnlichen Sites, von manchen auch etwas unscharf als Web2.0 Plattformen bezeichnet.

All diese Angebote leben davon, dass User Inhalte produzieren, veröffentlichen, kommentieren und oft auch Interessens-gruppen bilden. Umso mehr User so eine Plattform hat, umso höher ist auch ihr (Werbe/Markt)Wert.

Um nicht jeden Eintrag einzeln inhaltlich überpüfen zu müssen, dazu wäre auch eine unvorstellbare Menge an Redakteur_innen notwendig, wird diese Überprüfung auch in die Hände der User_innen gelegt.

Diese können Beiträge mit für sie inakzeptablem Inhalt »markieren«. Wird ein Beitrag von einer gewissen Anzahl von User_innen markiert, so wird dieser entweder gelöscht oder die Erreichbarkeit dieses Beitrags erschwert (erscheint nicht mehr bei einer Suchmaschinensuche oder eine Altersbestätigung wird verlangt, etc).

Bei dieser Praxis ergeben sich eine Reihe von Problemen und Fragen im Zusammenhang mit Zensur und freier Meinungsäußerung. Zweifelsfrei werden die meisten der Ansicht sein, es ist gut, dass ich einen Nazi-Beitrag markieren, und so seine Löschung veranlassen kann. Ganz anders sieht die Sache aber bei Beiträgen zu bestimmten sexuellen Vorlieben oder Neigungen aus.

User_innen, die bestimmte Beiträge markieren, sind dabei nicht an irgendwelche Regeln oder Vorgaben gebunden, sondern entscheiden einfach aus ihrem persönlichen Wertkontext heraus, ob eine Seite »gut« oder »böse« ist. Dieser Wertkontext ist sehr stark vom kulturellen Hintergrund einer Person abhängig. Eine streng christliche Person könnte ihre Probleme mit den Inhalten zum Beispiel einer Homosexuellen-Community-Seite haben.

Da eine Löschung von Inhalten, diese Inhalte können auch ganze Blogs sein, bei manchen Anbietern einfach automatisch nach einer gewissen Anzahl von »Markierungen« erfolgt, ist es ein leichtes, unliebsame Stimmen zum Schweigen zu bringen.

Diese Art der Zensur ist der der Zensur »von oben« sehr ähnlich, nur dass die »Zensor_innen« keiner staatlichen Behörde angehören und somit auch keinerlei gesetzlichen Kontrolle unterliegen. (Ich behaupte jetzt nicht, dass sowas wie gesetzliche Kontrolle funktioniert und was Tolles ist, aber zumindest besteht da theoretisch die Möglichkeit der Einflussnahme durch Bürger_innen).

Eine andere Art von »Zensur« in solchen sozialen Netzwerkcommunities ist das sogenannte »Trollen« oder »griefing«. Dabei werden Personen oder Gruppen öffentlich lächerlich gemacht, eine Diskussion mit »unsinnigen« Beiträgen sabotiert oder Menschen mit bestimmten Meinungen bzw. Seiten mit gewissen Inhalten diskreditiert.

Beide dieser Ausprägungen von Zensur schränken die freie Meinungsäußerung ein. Ein gewisses Maß an Beschränkung kann jedoch auch sinnvoll sein (wie zum Beispiel die bereits erwähnten Nazi-Seiten oder andere menschenverachtende Inhalte). Die Schwierigkeit besteht darin, diese Beschränkungen zu organisieren.

Die großen Firmen, die hinter den meisten sozialen Netzwerkseiten stehen, versuchen dies durch Nutzungsbedingungen zu regeln. Die User_innen dieser Services sind den Bedingungen der Firmen ausgeliefert und haben auf diese in der Regel keinen Einfluss, denn das würde bedeuten die Kontrolle an die Community abzugeben, die eigentlich nur dazu da sein sollte, sich zu vermehren und dadurch den Marktwert zu steigern.

Nationale Gesetze zur Zensur taugen auch nicht. Die aktuelle Debatte in Deutschland veranschaulicht das auch recht gut. Dort wird gerade mit vorgehaltener Kinderpornopropagandawaffe ein Gesetz zum Aufbau einer Zensurinfrastruktur geschaffen. Die Sperrliste soll geheim bleiben, damit gibt’s wie gesagt auch keine erwähnenswerte Kontrolle oder Einflussnahme.

Außerdem wird mit stiller Zensur ein Problem oft einfach nur versteckt und rückt nicht in das politische oder gesellschaftliche Blickfeld. Damit wird eine politische Debatte erheblich erschwert und das eigentliche Problem oft noch schlimmer. Technische Lösungen für soziale Probleme gibt es nun mal nicht.

Ein Weg eine möglichst große Vielfalt von Meinungen und Inhalten zu ermöglichen, ist eine Art »offene Zensur«. Die Community soll selbst bestimmen dürfen, nach welchen Kriterien zensuriert wird und eine Diskussion über die Löschung bestimmter Inhalte muss möglich sein. Dies setzt aber auch mehr inhaltliche Auseinandersetzung der Communitymitglieder untereinander voraus.

Ich denke es gibt keine perfekte Lösung dieses Problems, aber wir sollten uns dieser Vorgänge und Mechanismen im Spannungsfeld zwischen Zensur und freier Meinungsäußerung im Internet bewusst sein.

Der Zensur-Mob

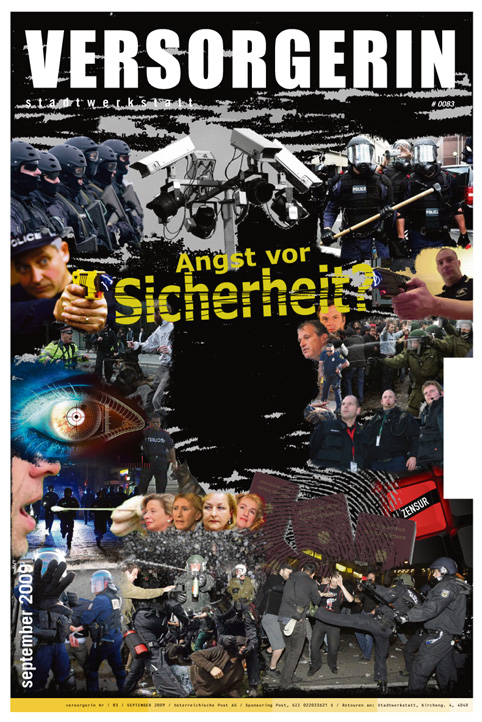

Peter Wagenhuber von servus.at und Funkfeuer Linz besuchte die »Technologie und Sicherheitskonferenz« in den Niederlanden und hörte u.a. einen brisanten Vortrag zur Zensur im Internet.

[1] Nähere Informationen zum Begriff Hacker gibt’s in der deutschsprachigen Wikipedia unter http://de.wikipedia.org/wiki/Hacker

[2] Informationen zu Funkfeuer gibt’s unter http://linz.funkfeuer.at

[3] Unter Firmware (vom engl. »firm« = fest) versteht man Software, die in elektronische Geräte eingebettet ist. (Quelle http://de.wikipedia.org/wiki/Firmware)

[4] dyne.org ist ein hierarchiefreies Kollektiv von Hacker_innen, die unter anderem auch die auf Multimediaproduktion ausgerichtete Linux Distribution dynebolic entwickeln. Mehr Information dazu unter http://dyne.org