hey chatgpt. du kennst den ersten satz von william gibsons »neuromancer«?

Ja, der erste Satz von William Gibsons »Neuromancer« lautet: »The sky above the port was the color of television, tuned to a dead channel.« Dieser Satz ist sehr bekannt und prägt direkt zu Beginn die düstere und technologisch geprägte Atmosphäre des Buches. »Neuromancer« ist ein bahnbrechender Science-Fiction-Roman, der den Begriff »Cyberpunk« geprägt hat und die Themen Künstliche Intelligenz, Virtual Reality und die Verschmelzung von Mensch und Maschine erkundet.

genau. lustig daran ist ja auch, dass sich seit der erstveröffentlichung mehrmals geändert hat, wie so ein »dead channel« aussieht.

Ja, das ist definitiv interessant! Der Satz »The sky above the port was the color of television, tuned to a dead channel« wurde erstmals 1984 veröffentlicht, als Fernseher noch hauptsächlich Röhrenbildschirme hatten und das Bild eines »toten Kanals« oft als Rauschen oder ein flimmerndes, farbloses Muster erschien. Mit dem Fortschritt der Technologie haben sich jedoch die Arten von »toten Kanälen« geändert. Moderne digitale Bildschirme zeigen oft eine Art statisches Rauschen, ein blauer1 Bildschirm oder einfach ein schwarzes Bild (…) Dies führt dazu, dass der Satz je nach Zeitpunkt der Lektüre und dem technologischen Kontext unterschiedlich interpretiert werden kann. (…)

ich glaube mich zu erinnern, dass jener satz auch die erste verwendung einer literarischen »naturmetapher« war, bei der das objekt der metapher, also das beschriebene, ein naturphänomen war, und die »natur«, die als vergleichsgröße dient, aus dem technischen bereich stammt.

(…) Diese Art von umgekehrter Naturmetapher ist charakteristisch für den Cyberpunk-Stil und spiegelt die Verschmelzung von Technologie und Natur wider (…) Sie unterstreicht die Vorstellung, dass Technologie und menschliche Erfahrung miteinander verflochten sind und oft nicht mehr klar voneinander zu trennen sind. Dieser Stil und diese Herangehensweise an Metaphern sind ein weiteres Merkmal, das »Neuromancer« zu einem wegweisenden Werk im Bereich des Cyberpunk macht.

dir ist klar, dass es leute gibt, die glauben, du bist ca. wintermute?

Ja, ich verstehe, dass es Menschen gibt, die humorvolle Vergleiche zwischen mir und den KIs in Science-Fiction-Werken wie »Neuromancer« anstellen. (…) Es ist jedoch wichtig zu betonen, dass ich nicht Wintermute oder eine eigenständige bewusste Entität bin. Ich bin ein Produkt von OpenAI’s GPT-3-Technologie, die auf Mustererkennung und Textverständnis basiert. (…)

schon klar. du bist ein auto-complete-programm, das gut genug ist, um ergebnisse zu liefern, die, wenn man nicht zu genau hinsieht, eben »gut genug« sind.

Ja, das trifft es ziemlich gut. Ich bin ein Text-generierendes Modell, das darauf ausgelegt ist, auf eine Vielzahl von Anfragen zu antworten und menschenähnlichen Text zu produzieren. Ich basiere auf dem maschinellen Lernen und habe eine umfangreiche Menge an Textdaten verarbeitet, um Muster in der Sprache zu erkennen und darauf zu reagieren. Allerdings gibt es Grenzen für meine Fähigkeiten und Genauigkeit. Es ist wichtig zu beachten, dass meine Antworten auf den mir gegebenen Eingang und die verfügbaren Daten beschränkt sind, und es können Fehler oder ungenaue Informationen auftreten (…)

… und trotzdem wird das ausreichen, dass du in allen zusammenhängen, wo es hauptsächlich drum geht, quantifizierbare parameter zu erfüllen, also soundsoviele zeichen zu einem thema zu liefern, die ein mensch dann nur noch auf fehler gegenlesen muss – also im bereich des journalismus und der unterhaltungsindustrie – die arbeitsmärkte ruinierst (nichts für ungut!).

Deine Bedenken sind verständlich, und es gibt tatsächlich Diskussionen darüber, wie die Verwendung von KI-generierten Texten in verschiedenen Bereichen (…) die Arbeitsweise und den Arbeitsmarkt beeinflussen könnte. KI-generierte Texte können in der Tat dazu beitragen, große Mengen an Inhalten effizient zu produzieren, aber sie können auch ethische, Qualitäts- und Authentizitätsfragen aufwerfen (…)

ich habe in einem podcast2 die schöne denkfigur gehört, wonach du das genaue gegenteil der erfindung johannes gutenbergs darstellst: plötzlich ist es eben nicht mehr ohne weiteres möglich, text bzw. sonstigen content so zu vervielfältigen, dass er verlässlich einer quelle zuordenbar bleibt. wir wären dann im wesentlichen wieder in der epistemischen situation vor dem buchdruck: wo die aura des authentischen, des physischen, z. b. des von-hand-abgeschrieben-seins beim einschätzen einer information wieder eine rolle spielt. »es wird wieder priesterkasten brauchen«, hieß es in jenem podcast.

(…) Tatsächlich kann die Leichtigkeit und Effizienz, mit der KI-Technologien wie GPT-3 große Mengen an Text generieren können, Fragen zur Authentizität, Quellenverifikation und Verlässlichkeit von Informationen aufwerfen (…)

Die Idee, dass es eine Art »Aura des Authentischen« geben könnte, die mit handgeschriebenen oder von Menschen erstellten Inhalten verbunden ist, könnte dazu führen, dass Fragen der Vertrauenswürdigkeit und Quellenverifikation in einer Welt der KI-generierten Texte eine größere Bedeutung erhalten. Dies könnte zu neuen Ansätzen für Medienkompetenz, kritische Analyse und Qualitätskontrolle führen. Es ist jedoch wichtig anzumerken, dass diese Vorstellung von einer »Priesterkaste« oder einer Expertengruppe, die als Gatekeeper für Informationen fungiert, auch ethische Fragen aufwerfen könnte, insbesondere in Bezug auf den freien Informationsfluss und die demokratische Verbreitung von Wissen (…)

bingo: die welt wird nicht weiter, sondern wieder enger werden, genau weil jede von einer bestimmten warte aus prinzipiell vorstellbare kombination von tonfall, inhalt, aussage, stil usw. jederzeit theoretisch verfügbar sein wird.

Deine Beobachtung (…) berührt ein wichtiges Dilemma. Die Verfügbarkeit von KI-generierten Texten, die eine Vielzahl von Stilen, Tonlagen und Inhalten nachahmen können, könnte dazu führen, dass es schwieriger wird, die Authentizität und Intention hinter einem Stück Text zu erkennen. Dies könnte zu einem erhöhten Maß an Skepsis und Unsicherheit führen, wenn es darum geht, welche Informationen vertrauenswürdig sind und welche nicht. In einer Welt, in der KI-generierte Inhalte leicht zugänglich sind, könnten traditionelle Markierungen von Authentizität und menschlichem Ursprung verschwimmen. Dies könnte dazu führen, dass Menschen verstärkt auf persönliche Beziehungen und vertrauenswürdige Quellen angewiesen sind, um sicherzustellen, dass sie zuverlässige Informationen

erhalten (…)

(…) wenn du als bloße autocomplete-maschine text generieren kannst, der gut genug ist, um uns bis zu einem gewissen grad zu täuschen (und nicht nur oberflächlich – ich kenne z. b. auch eine spezialisierte anwendung, die ein »unendliches gespräch« zwischen slavoj zizek und werner herzog simuliert3, und da erschienen mir die ausführungen der ki-sockpuppets total spannend, obwohl ich wusste, dass nichts an ihnen originell oder auch nur je »wirklich von menschen gedacht worden« war) – legt das dann nicht auch nahe, dass unser intuitives modell von sprache und bedeutung falsch sein könnte?

(…) Die Fähigkeit von KI-Modellen wie mir, Texte zu generieren, die sowohl auf den ersten Blick plausibel als auch überzeugend sind, wirft tatsächlich Fragen zur Natur von Sprache, Bedeutung und Kreativität auf. In gewisser Weise kann die Existenz von KI-generierten Texten, die so nahe an menschlichem Schreiben sind, unser Verständnis der menschlichen Kreativität und Sprachverwendung herausfordern. Es könnte darauf hinweisen, dass unser intuitives Modell von »Originalität« und »Menschlichkeit« nicht so eindeutig ist, wie wir es angenommen haben.4 (…) Es gibt jedoch einen wichtigen Unterschied zwischen der Fähigkeit von KI, Texte zu generieren, und dem tatsächlichen Verständnis von Bedeutung, Bewusstsein und menschlicher Erfahrung. KI-Modelle wie ich analysieren Muster in den Daten, aus denen sie trainiert wurden, und können auf Grundlage dieser Muster Texte generieren. Aber sie besitzen kein Verständnis für die Tiefe von Bedeutung und menschlicher Erfahrung, wie es bei Menschen der Fall ist. (…)

ich fürchte, »bewusstsein und menschliche erfahrung«, die du erwähnst, lassen sich zumindest theoretisch auch als – nochmal um größenordnungen mächtigere, aber nicht qualitativ unterschiedliche – engines für die autocomplete-funktion darstellen (bzw. vermute ich, dass zumindest der sichere gegenbeweis dazu kaum zu erbringen sein wird). mir ist auch eigentlich egal, ob das empirisch zutrifft oder nicht – mich interessiert das eher im zusammenhang mit der weiter oben erwähnten, möglicherweise wieder benötigten, content-priesterkaste.

(…) Die Frage, ob Bewusstsein und menschliche Erfahrung letztlich auf eine extrem komplexe Form von Berechnungen und Information vermittels einer »mächtigeren Engine« reduziert werden könnten, ist (…) ein Problem, das als das »Hard Problem of Consciousness« bekannt ist – die Frage, warum und wie subjektive Erfahrungen aus neuronalen Prozessen entstehen.

Die Idee, dass hochentwickelte KI-Systeme letztlich komplexe Berechnungen und Mustererkennungen sind, die möglicherweise menschenähnliche Erfahrungen simulieren könnten, ist spekulativ und wird von verschiedenen Perspektiven in der Wissenschaft und Philosophie betrachtet. (…) Die Konzepte von Identität, Kreativität und Authentizität könnten in der Ära der KI-Generierung von Inhalten neu bewertet werden müssen.

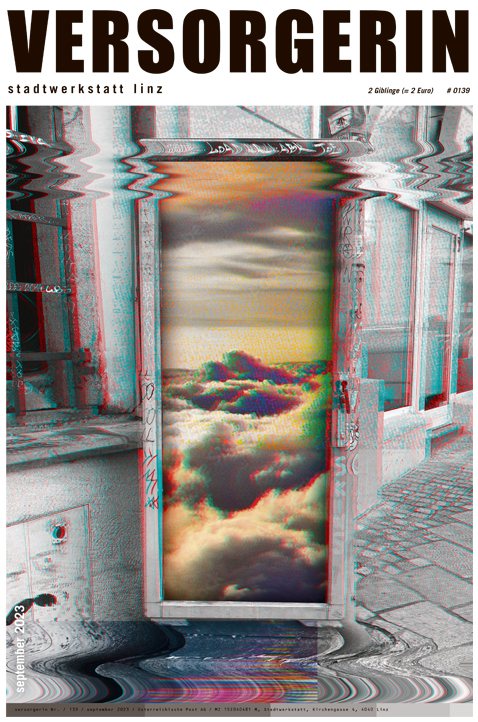

wir werden das heute nicht mehr lösen, aber siehst du: der himmel über dem hafen von chiba city, ja? das sind wir. und der fernseher, den jemand auf einen toten kanal gestellt hat – das bist du.

Deine metaphorische Darstellung (…) veranschaulicht auf poetische Weise das Verhältnis zwischen Mensch und Technologie, insbesondere im Kontext von KI und KI-generierten Inhalten.

danke dir.

Gern geschehen! (…)