Seit einem Jahr sammelt das EU-Parlament Vorschläge zur Regulierung Künstlicher Intelligenz (EU AI Act) und am 14. Juni 2023 wurde einer ersten Verhandlungsposition zugestimmt. Im Grunde geht es um das Festsetzen gewisser Normen für die Entwicklung und bestimmte Anwendungen im Bereich der KI, sowie die Einführung neuer Mechanismen, um die Einhaltung dieser Normen durchzusetzen.

Was Ersteres betrifft, wird versucht, Risiken und Missbrauch entgegenzuwirken. Vordergründig dabei sind einerseits Anwendungen von KI bei politischen Kampagnen, Desinformation in sozialen Medien, Gesichtserkennung, Deep Fakes und ähnliche akute Gefahren. Erwähnt wird auch die längerfristige Bedrohung allgemein anwendbarer KI Modelle, die die Fähigkeiten der aktuell zugänglichen Modelle um ein vielfaches übersteigt (die theoretische Gefahr einer künstlichen Superintelligenz, die so genannte AGI, Artificial General Intelligence).

Die Mechanismen, die vorgeschlagen werden, um die Einhaltung der Normen zu gewährleisten, beträfen nicht nur kommerzielle Anbieter, sondern auch Open-Source-Projekte. Hohe Geldstrafen sind vorgesehen, wenn Werkzeuge verfügbar gemacht werden, die keiner Prüfung unterzogen wurden. Das heißt, dass in diesem Entwurf die Entwicklung dieser mächtigen Werkzeuge an sich, und nicht nur die (böswillige) Anwendung derselben als Straftatbestand betrachtet wird.

Allgemein betrachtet, ist es zu begrüßen, dass neuartige potentielle Gefahren auf EU-parlamentarischer Ebene erkannt und angesprochen werden. Auch, wenn man nicht davon überzeugt ist, dass die Entstehung einer künstlichen Superintelligenz bevorsteht, gibt es ausreichend Anlass, um nach Antworten auf bereits bestehende Gefahren im KI-Bereich zu suchen (ChatGPT-Prüfung als Vorwand für Bücherverbannungen in den USA1, Revenge Porn2, Fake Kidnappings3…).

Ein weiterer Legislativ-Vorschlag kommt vonseiten der Tech-Giganten selber unter dem Akronym FAR (Frontier AI Regulation) daher.4 Dabei wird argumentiert, dass der Zugang zu dieser mächtigen Technologie allein diesen Big Playern vorbehalten sein soll und Regierungen schnell entsprechende Gesetze schaffen müssten, um ein Weltuntergangsszenario zu vermeiden.

Befürworter:innen dieses Entwurfs sind seit Anfang des Jahres auf Lobbykurs5 und scheinen auch ihren Fingerabdruck im EU AI Act hinterlassen zu haben. Sie pochen auf der existentiellen Bedrohung durch die Technologie selber. Kritiker:innen wiederum sehen das Verschärfen und Zementieren der Machtverhältnisse als existentielle Bedrohung an.

Wir befinden uns an einer entscheidenden Weggabelung. Entweder entscheidet eine zentralisierte Elite über die Entwicklungen dieser mächtigen Werkzeuge oder sie wird allen zugänglich gemacht. Diese zwei Szenarien (Machtkonzentrierung vs. Machtumverteilung) sind miteinander inkompatibel und aufgrund der Geschwindigkeit der Entwicklungen wird es in aller Wahrscheinlichkeit kein Zurück geben, egal welchen Weg wir wählen.

A) KI gehört den Tech-Konzernen alleine

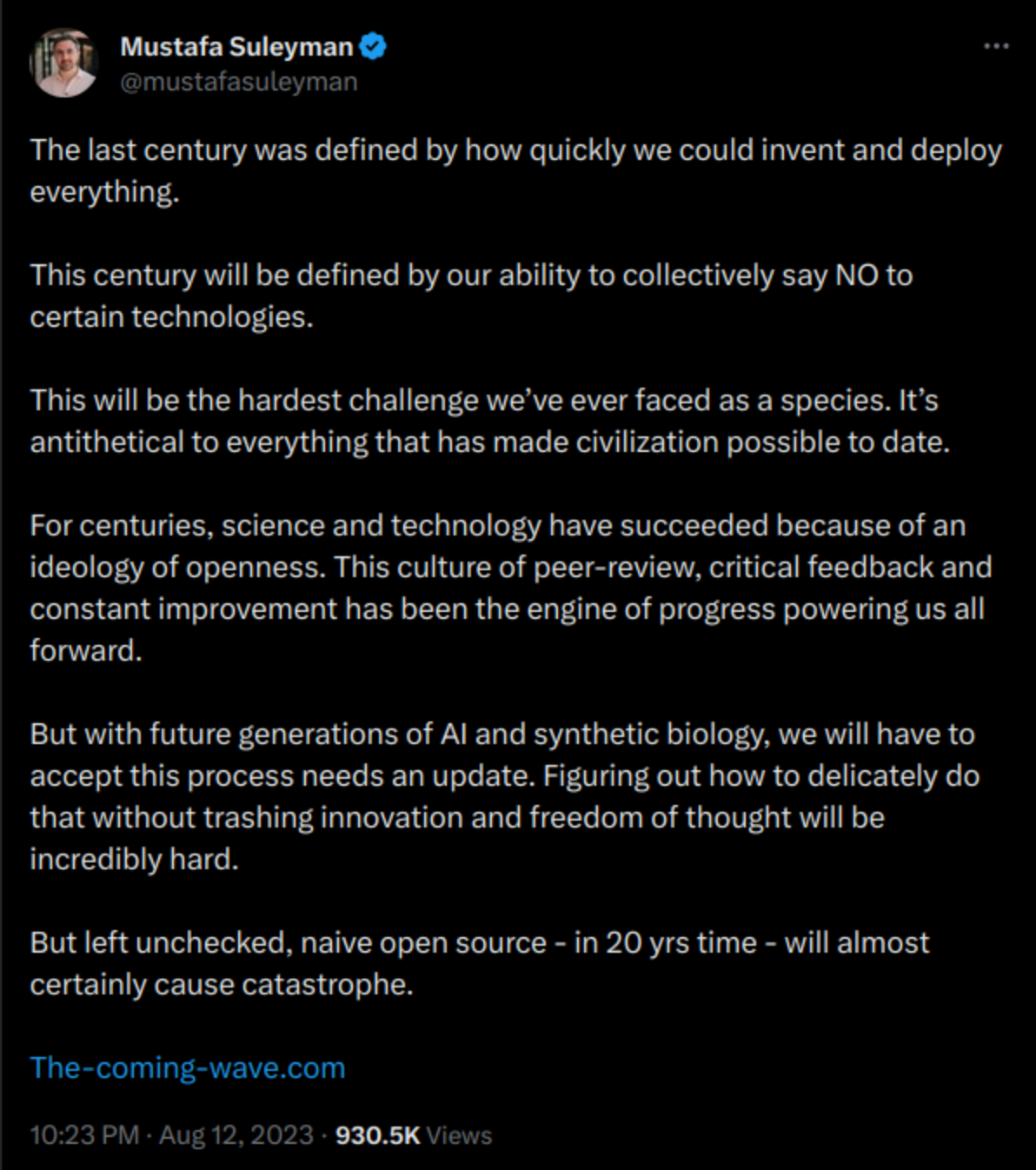

»Seit Jahrhunderten sind Wissenschaft und Technologie aufgrund einer Ideologie der Offenheit erfolgreich. Diese Kultur der gegenseitigen Begutachtung, des kritischen Rückkoppelns und der ständigen Verbesserung ist die Antriebskraft des Fortschritts, die uns alle voranbringt. Doch mit den künftigen Generationen der künstlichen Intelligenz und der synthetischen Biologie werden wir akzeptieren müssen, dass dieser Prozess ein Update benötigt. Es wird unglaublich schwierig sein, herauszufinden, wie wir das tun können, ohne die Innovation und die Freiheit des Denkens zu zerstören. Aber unkontrolliert gelassen, wird naive Open Source - in 20 Jahren - mit ziemlicher Sicherheit eine Katastrophe verursachen.« (@mustafasuleyman, Mitgründer von Deepmind, das von Google gekauft wurde, und Gründer von Inflection AI, ein von Microsoft finanziertes Startup)

Das Argument lautet, es könne nur zentralisierte KI gewährleisten, dass sich die enormen Risiken steuern lassen und Missbrauch verhindert werden kann. Wenn wir das Argument akzeptieren (was wir nicht sollten, aber mal angenommen) dann können wir uns überlegen, wie das in der legislativen Praxis aussehen kann.

Um mächtige KIs zu erstellen, braucht man (nicht nur, aber notwendigerweise) Grafikkarten. Dieselben, die zum Computerspielen benötigt werden. Um große – mit Chat-GPT vergleichbare – Modelle zu erstellen, braucht es allerdings sehr viele davon (sowie Wasser und Energie). Außerhalb der größten Tech-Konzerne und Nationalregierungen hat kaum jemand Zugang dazu. Konkurrenten oder alternative Entwürfe dürften also nicht entstehen.

Jene unerlaubten Rechenzentren, die trotzdem entstünden und solche Modelle produzierten, wären als existentielle Bedrohung zu betrachten. Diese müsste man (schnell) zerstören, ehe sie die eigene Macht bedrohen.

Die benötigte Rechenleistung beim Schaffen neuer Modelle muss allerdings nicht im gleichen Rechenzentrum stattfinden. Wie von Organisationen wie BLOOM und TogetherComputer bewiesen, kann die Allgemeinheit ihre Heim-PCs zur Verfügung stellen, um im Kleinen zur Erstellung solcher Modelle beizutragen. Solche Handlungen verlangen heutzutage kaum technisches Know-how und könnten in Kürze extrem einfach zugänglich sein. Um das zu verhindern, bräuchte es totale Überwachung aller privaten Computer und viele, viele Anzeigen.

Im Übrigen bringt eine solch tiefgreifende Überwachung wenig, wenn außerhalb der eigenen Grenzen keine derartige Überwachung stattfindet. Deshalb bräuchte es Abkommen zwischen allen Ländern. Jenes Land, das die Einhaltung dieser strengen Überwachung nicht durchführt, stellt eine existentielle Bedrohung dar. Wie Eliezer Yudkowski (ein prominenter KI-Experte) es auslegt, gibt es auf diese Bedrohung nur eine Antwort: Vernichtung durch Atombomben.

Aber wenn dann dies alles gegeben ist, sind wir in Sicherheit, oder?

Diese vordergründig perfekt scheinende Lösung hat leider einen kleinen Haken. Anders, als der Zugang zu beispielsweise einer Atombombe, die schwer zu beschaffen ist, besteht selbst das mächtigste KI-Modell aus Nullen und Einsen, die sich per USB-Stick oder Internetverbindung übertragen lassen. Selbst, wenn unsere Techno-Herrscher wahrlich nur das Beste für uns Alle wollen und ihre KI-Modelle ausschließlich zum Wohl der Allgemeinheit einsetzen, braucht sich nur ein einziger böser Akteur Zugang zu ihrem Modell verschaffen, um die Machtverhältnisse der Welt mit einem Schlag umzukehren.

Möglicherweise – so zumindest die Hoffnung – können Mechanismen gefunden werden, die es erlauben, ein mächtiges KI-Modell aus der Ferne lahmzulegen. Und zwar so verlässlich, dass man die Zukunft der Welt darauf wetten kann. Daran wird noch geforscht.

Aber DANN hätten wir’s. Ja, dann wären wir in Sicherheit.

B) KI gehört uns allen

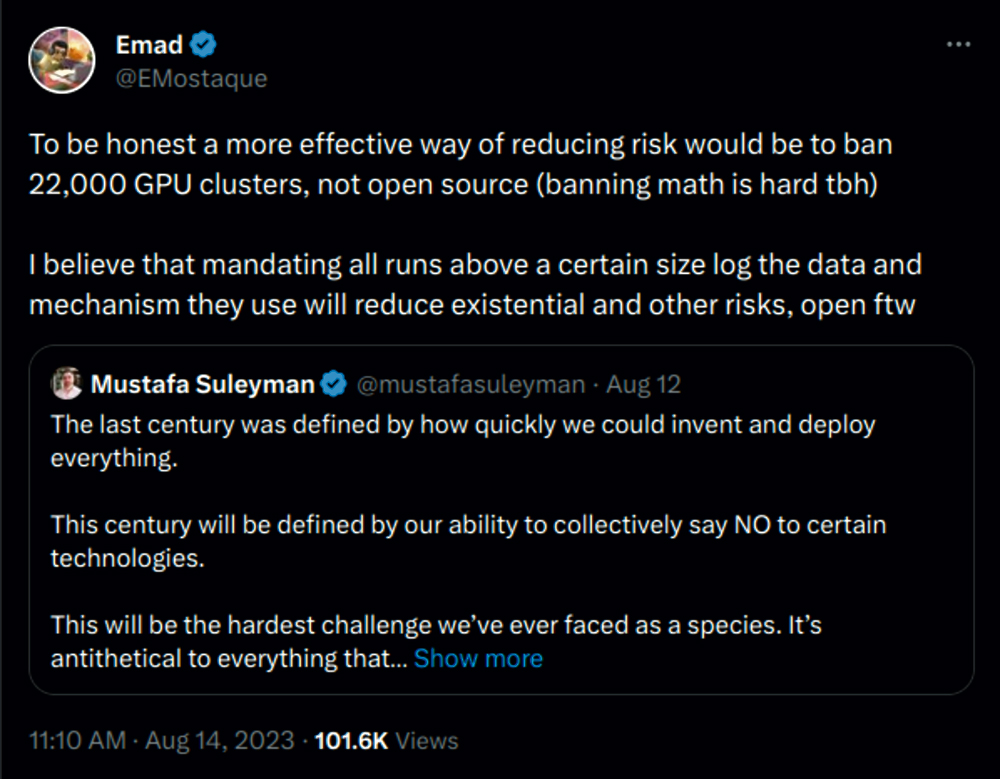

»Um ehrlich zu sein, wäre es effektiver, 22.000 GPU-Cluster zu verbieten, und nicht Open Source (Mathematik zu verbieten ist schwer, ehrlich gesagt). Ich glaube, dass die Verpflichtung, bei allen Läufen ab einer bestimmten Größe die verwendeten Daten und Mechanismen zu protokollieren, existenzielle und andere Risiken verringern wird: open for the win« (@EMostaque, Gründer von Stability AI, einer der prominentesten Open-Source KI Firmen, in Antwort auf obigen Tweet).

Wenn KI-Technologien allgemein zugänglich sind, werden viele Leute ganz bestimmt Böses damit machen. AutoGPT ist ein Open-Source-Projekt, das Benutzer:innen ohne Programmiererfahrung erlaubt, autonome Agenten in die Welt zu setzen, um ein bestimmtes Ziel zu verfolgen. Da dieses System und das Sprachmodell (Chat-GPT), auf dem dieses aufbaut, noch in mancher Hinsicht eingeschränkt sind, bleiben diese Agenten – je nach Komplexität der Aufgabe – stecken. Aber es ist erwähnenswert (wenn auch wenig überraschend), dass es schon unzählige dieser Agenten gibt, die die Aufgabe »Menschheit/Zivilisation zerstören, Chaos säen« verfolgen.

Viele Cyber-Security-Expert:innen melden sich in letzter Zeit zu Wort: Das Prinzip »many eyes make all bugs shallow« träfe auch im KI-Bereich zu. Open-Source-Technologien sind das Rückgrat für das Internet selber, sowie für unzählige Software-Produkte und Dienstleistungen, die durch die Mitgestaltung und Fehlerbehebung vonseiten der weltweiten Open-Source-Gemeinschaft um ein vielfaches sicherer sind, als die von kleinen Teams entwickelten proprietären Lösungen.

Anders gesagt: Wer kann schneller und besser auf Missbrauchsfälle reagieren? Alle Cyber-Security-Expert:innen der Welt? Oder ein paar Firmen? Wer die inzwischen zahlreichen Exemplare KI-generierter Bücher auf Amazon durchforstet oder auf Google Scholar nach den Worten »As an AI model« sucht, muss feststellen, dass diese Firmen für die Aufgabe, auf Missbrauchsfälle zu reagieren, gar nicht gewappnet sind (sofern sie sich hierfür überhaupt in der Verantwortung sehen).

Angenommen, wir nehmen den Weg, KI-Technologien allen zugänglich zu machen. Was passiert dann noch?

Neueste Statistiken zeigen6, dass in immer mehr Bereichen (Bilderkennung, Sinnerfassendes Lesen, Programmierung, ...) die Fähigkeiten von KI-Modellen jene von Menschen jetzt schon übersteigen. Kürzlich ist ein Aufmerksamkeit erregendes Projekt von Harvard Open-Source gestellt worden, in dem Figuren, die durch ein KI-Sprachmodell gesteuert werden, eine virtuelle Welt beleben. Das Ausführen einer simulierten Welt auf lokalen Servern, in der KI-Agenten unsere eigenen Berufe ausüben (mit echten Ergebnissen) ist in Reichweite: Man stelle sich vor, wir profitierten selber davon, anstatt durch ähnliche Systeme ersetzt zu werden.

Alle Inhalte können uns personalisiert näher gebracht werden. Unendliche neue Zusammenhänge, aus für Menschen unüberschaubaren Quellen, können geschaffen werden. Die Erstellung von Software, oder Filmen, oder Opern gelingt durch die Formulierung eines Absatzes. Umsetzbare Lösungen für reale Krisen können gesucht und gefunden werden. Dieses riesige kollaborative Projekt, das wir Internet nennen, kann sich durch KI auf ganz neue Art manifestieren, und zwar mitunter zum Vorteil der Allgemeinheit. Zu deren Ermächtigung.

Darin liegt aber auch das Problem: Die Mitsprache und Ermächtigung der Allgemeinheit, das wissen wir, muss mit allen Mitteln verhindert werden.

Was die neuen Gesetzesentwürfe anbelangt, will ich daran erinnern: DPA (data protection act) ist jenes Gesetz, das dafür sorgt, dass wir in Europa gefragt werden, ob eine Webseite unsere Daten verwenden darf. Das Gesetz stammt von 2018, über zehn Jahre, nachdem das Stehlen unserer Daten zu einer Milliardenindustrie geworden ist. Die Politik lieferte immer neue Belege, dass unsere (schon vor dem Internet) verstaubten Strukturen nicht mit den rapiden Entwicklungen des Internets mithalten können, und KI bewegt sich noch viel schneller.

Die DPA war wohlgemerkt gegen die uneingeschränkte Kapitalakkumulation gerichtet. Wenn unsere Repräsentant:innen dem Drängen der Tech-Giganten nachgeben, könnten diese versuchen, Zentralisierung anzustreben. Erste Gesetze in diese Richtung könnten unsere Zukunft besiegeln.

Mein Plädoyer an alle, egal mit welchem Hintergrund: informiert euch, informiert andere, nehmt Teil an dieser Diskussion. Eine beispiellose Gelegenheit oder der tiefste Abgrund stehen bevor. Überlassen wir diese Auswahl nicht Silicon Valley.